Tesla claimt met Autopilot voorop te lopen met autonoom rijdende auto’s. Nu ze klanten laten testen met hun nieuwste software, blijkt echter dat van echte autonomie nog geen sprake is.

FSD Beta

Volgens Tesla zijn hun auto’s geschikt voor autonoom rijden. Het zit zelf in de naam: Tesla Autopilot of FSD, wat staat voor Full Self Driving. Hoewel Tesla zijn software goed voor elkaar heeft, zit Tesla echter net als alle andere merken (op Honda na) pas op niveau 2 van autonoom rijden. Dit betekent dat de bestuurder ook in een Tesla te allen tijde zelf moet opletten. Door Tesla’s claims en naamgeving zijn er mensen die menen dat hun Tesla autonoom kan rijden, wat een aantal keer al dodelijk is afgelopen.

In oktober vorig jaar konden mensen zich inschrijven om de nieuwste software te testen, de FSD Beta. In gelekte e-mails aan de autoriteiten van Californië moest Tesla echter toegeven dat ook de FSD Beta niet verder gaat dan autonomie niveau 2 – waarbij de bestuurder altijd controle moet houden. Nog verre van autonoom rijden dus.

Hoeveel mensen er meedoen aan de FSD Beta test is onduidelijk. Elon Musk claimt meer dan duizend, andere bronnen hebben het over 200 mensen, waarvan er slechts een paar tiental niet voor Tesla werken. De deelnemers kunnen de nieuwste software op hun eigen Tesla testen, waarbij de testresultaten automatisch naar Tesla gaan. Verschillende deelnemers hebben echter ook hun bevindingen gedeeld op YouTube, waardoor we kunnen zien hoe ver Tesla werkelijk is met autonoom rijden.

Links afslaan

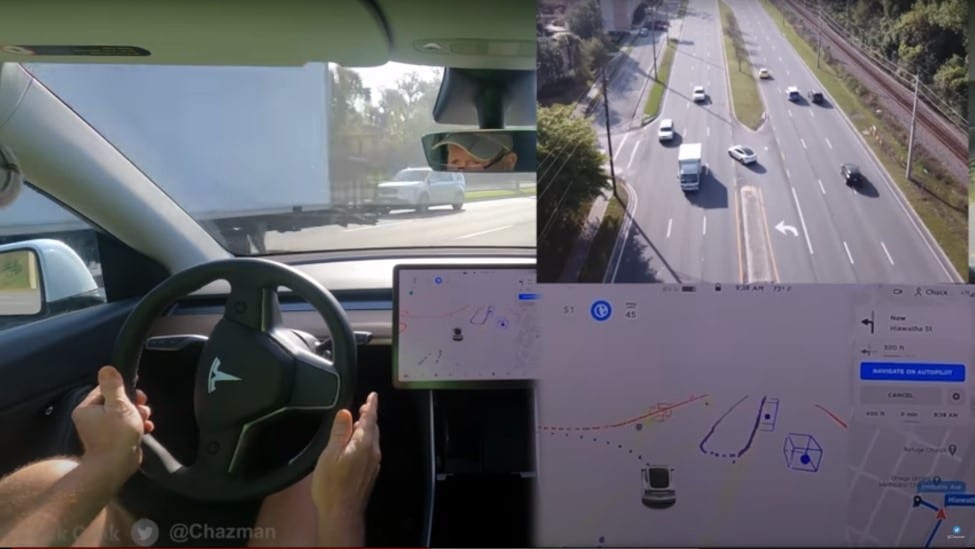

Zo filmde Chuck Cook vanuit zijn Tesla en met een drone hoe zijn Tesla met de nieuwste FSD Beta, versie 8.2, omgaat met linksaf slaan op een drukke weg. Voor mensen een overzichtelijke kruising, maar de Tesla heeft er moeite mee. Van de acht pogingen falen er zes. Drie keer moet de bestuurder ingrijpen om een ongeval te voorkomen: Tesla Autopilot wil de weg oversteken terwijl er verkeer aan komt snellen. Andere keren blijft de Tesla onnodig lang staan terwijl de weg vrij is, of steekt hij zo twijfelend over dat de bestuurder de controle moet overnemen.

De video van Chuck legt een aantal gevaren bloot. Chuck constateert op zijn scherm dat de Tesla veel minder voertuigen identificeert dan er daadwerkelijk rijden. Oftewel: de Tesla ziet veel auto’s niet aankomen. Bovendien gaat de Tesla zonder waarschuwing rijden, waarbij de bestuurder volledig overvallen wordt. In één geval kon Chuck nog maar net op tijd ingrijpen terwijl de Tesla zichzelf voor een aanstormende auto gooit.

Stadsverkeer

Een andere video toont een test met FSD Beta, versie 8.2, in het stadsverkeer van Oakland, Californië. Hoewel met name de passagier alles goed probeert te praten wat de Tesla doet, kan ook hij niet ontkennen dat het een aantal keer goed mis gaat.

Soms handelt Autopilot slechts onhandig, maar een aantal keer veroorzaakt de Tesla bijna een ernstig ongeval. Alleen ingrijpen van de bestuurder voorkomt erger. We zien de Tesla onder andere oversteken terwijl er auto’s aankomen, op de verkeerde weghelft rijden, richting tegemoetkomend verkeer gaan en over busbanen en verdrijvingsvakken rijden.

De video maakt duidelijk dat Tesla Autopilot nog niet klaar is voor de stad. Vaak staat de auto besluiteloos stil of slingert hij twijfelend over de weg. De sensoren laten de auto regelmatig in de steek: Autopilot wil een baan opschuiven terwijl er een auto naast hem rijdt, wil rechtdoor een muur in en rijdt de stoep op. Het systeem schakelt zichzelf meermalen zonder waarschuwing uit, omdat het de situatie niet snapt, niet kan zien of gewoon zomaar.

Gevaarlijker dan gewoon autorijden

De video’s tonen niet alleen dat Tesla Autopilot niet klaar is voor autonoom rijden, maar ook het gevaar van niveau 2 autonomie. In een auto zonder autonomie bedien alleen jij het gaspedaal en de rem: als jij niks doet, doet de auto ook niks. Bij software zoals de Tesla FSD Beta moet je juist veel beter opletten dan normaal. De auto handelt namelijk uit zichzelf en maakt daarbij verkeerde inschattingen. Hierdoor moet je niet alleen op het verkeer letten, maar ook voorbereid zijn op de auto die ineens iets onverwachts gaat doen.

Sommige deskundigen zeggen dat niveau 2, een tussenvorm naar autonoom rijden, gevaarlijker is dan geen enkele autonomie. De reden dat er nog weinig ongelukken gebeuren met deze rijhulpmiddelen, is volgens hen dat de software gewoon nog zo slecht is dat mensen het niet vertrouwen. De FSD Beta van Tesla gaat verder dan andere software, maar toont direct zien dat het nog volledig onbetrouwbaar is en onmiddellijk grote ongelukken zou veroorzaken.

Je kunt dan ook vraagtekens zetten bij de beslissing van Tesla om de FSD Beta door klanten te laten testen op de openbare weg. Daarbij blijft Tesla de indruk wekken dat hun auto’s gereed zijn voor autonoom rijden, terwijl het tegendeel waar is. Op dit moment zijn we dus afhankelijk van enkele willekeurige Youtubers om de waarheid te tonen: Tesla Autopilot, oftewel FSD Beta, versie 8.2 is nog ver verwijderd van autonoom rijden.